Recientes estudios nutricionales señalan la influencia negativa que tienen en el organismo las conocidas como «grasas insaturadas trans». Esta advertencia entra en conflicto con la creencia, bastante extendida en los últimos tiempos —en gran parte por el efecto de la publicidad—, de que las grasas insaturadas son beneficiosas para la salud, por oposición a las grasas saturadas. Intentemos arrojar un poco de luz a la cuestión.

Las grasas saturadas, denominadas así porque en su estructura química no «admiten» más hidrógeno, se caracterizan por estar constituidas por ácidos grasos saturados. Sin entrar en detalles sobre su estructura química, estos ácidos grasos saturados se pueden visualizar como largas cadenas moleculares lineales (En la figura, A). Los ácidos grasos insaturados (En la figura, B y C), se caracterizan por la presencia de una o varias insaturaciones (químicamente, puntos de esas cadenas que «admiten» la adición de hidrógeno). En nuestra visualización, una insturación se traduce en dos giros de 120º consecutivos en un punto de la cadena. Además, son «uniones rígidas», de modo que aparecen dos posibilidades:

a) En el caso de que ambos giros de 120º sean hacia el mismo lado (cis en latín), el motivo estructural resultante es el representado en B. Estas estructuras de cadenas curvadas no se empaquetan con facilidad (pensemos, por ejemplo, en hacer gavillas o en apilar leños de semejante forma). Tal empaquetamiento deficiente en el nivel molecular, se traduce en el nivel macroscópico —en la apariencia de las cosas que vemos con los ojos—, en que este tipo de grasas son normalmente líquidas. Esto es lo que ocurre con los aceites, que generalmente proceden de los vegetales, y en algunos casos, del pescado. Esta propiedad de ser líquidos a temperatura ambiente, hace que estas grasas sean más «fluidas», por así decirlo, y son las que se relacionan con una dieta más sana, niveles más bajos de lipoproteínas de alta densidad (el denominado colesterol «malo»), menor riesgo de problemas cardiovasculares, etc.

b) Cuando ambos giros en la cadena se hacen hacia lados apuestos (trans en latin), el motivo estructural resultante es el representado en C. Las cadenas mantienen la linealidad y se pueden empaquetar bien. Se intercalan sin dificultad en los haces formados por las grasas saturadas (A en la figura) y, como ellas, forman grasas sólidas, que abundan en los tejidos grasos de los animales. Las grasas saturadas, aunque necesarias —son la reserva principal de energía en el cuerpo—, cuando se acumulan en exceso son las principales responsables de la obesidad y de otras enfermedades relacionadas (diabetes, formación de placas de ateroma en las arterias, etc.), por lo que se recomienda controlar su consumo. En el caso de las grasas insaturadas trans, en principio extrañas a nuestro organismo, además de que no poseen las características beneficiosas de los ácidos grasos cis, existe un problema adicional: en el estudio realizado, se alimentaron dos grupos de monos durante seis años, controlando su dieta. El primer grupo, cuya dieta incluía grasas insaturadas cis, aumentó su peso en un 1,8%. El otro grupo, en cuya dieta se incluyeron grasas insaturadas trans, aumentó su peso en un 7,2%, pese a que se esperaba que no hubiese una diferencia apreciable, ya que la ingesta calórica era la misma. El estudio concluye que el consumo de ácidos grasos insaturados trans fomenta el aumento de peso.

¿De donde provienen las grasas insaturadas trans? En primer lugar,del proceso de hidrogenación de los aceites vegetales. Con este proceso químico, los aceites vegetales se «saturan» de hidrógeno, convirtiéndose en grasas saturadas, sólidas. (Son menos saludables, pero dan una apariencia mucho mejor al producto. Nadie se comería a gusto un bollo o una galleta que rezumase aceite, aunque eso es precisamente lo que ocurirría si no se usasen grasas saturadas (o insaturadas trans) en su elaboración. Pensemos en ciertos dulces caseros elaborados con aceite de oliva, que sí tienen ese aspecto oleoso.) En este proceso de hidrogenación, parte de las grasas no se saturan, sino que acaban isomerizándose, que es la palabra usada para designar la transformación de las uniones de tipo cis a las de tipo trans (de B a C, en la figura). En segundo lugar, el calentamiento prolongado de los aceites (por ejemplo, en freidoras) también acaba produciendo estos procesos de isomerización.

Alberto Soldevilla

Categoría: Química

martes, julio 04, 2006

Sobre las grasas insaturadas

Publicado por

AITRi

en

10:52 a. m.

2

comentarios

![]()

lunes, junio 26, 2006

Antibióticos: uso y abuso

La utilización de antibióticos en medicina es uno de los grandes logros del ser humano en el siglo XX. Gracias a su empleo, que comenzó durante la segunda guerra mundial, enfermedades como la tuberculosis, la neumonía o la escarlatina que fueron la primera causa de muerte, son mucho menos graves en la actualidad.

Sin embargo, la batalla contra las enfermedades infecciosas no está ganada. A través de mutaciones, las bacterias han desarrollado resistencias que han reducido la eficacia de los antibióticos, incluso de los más potentes.

Ante estos datos,

Cada vez que tomamos antibióticos sin necesidad, como al usarlos contra infecciones víricas como la gripe, o no completamos un tratamiento adecuadamente, las bacterias que se encuentran de forma natural en nuestro organismo desarrollan resistencias que posteriormente son propagadas.

Los antibióticos han salvado millones de vidas pero debemos consumirlos más prudentemente o pondremos en peligro su benéfica acción.

David Sucunza

Categoría: Medicina

Publicado por

AITRi

en

1:03 p. m.

2

comentarios

![]()

jueves, junio 08, 2006

Gallinas, huevos y la evolución de las especies

Saludos. Lo prometido es deuda, así que ahí va una nueva contribución. (Me ha quedado un poco largo, ya que soy proclive a la textorrea; espero que me disculpéis.) En una entrada anterior, ¿el huevo o la gallina?, surgió un interesante debate, lleno de jugosos comentarios, que finalmente nos condujo al mecanismo de la evolución de las especies. Como es un tema muy interesante y además parece que está de moda cuestionarlo, me voy a arriesgar a opinar (e, inevitablemente, a teorizar) sobre el caso. Es muy posible que cometa errores o demuestre mi falta de conocimiento sobre biología, genética y evolución —entre otros—, pero, por otro lado, quizá pueda estimular un debate aún más interesante, que suscite la participación de los lectores más versados en esta materia. Y hasta podemos llegar a alguna conclusión. Allá voy, pues:

De acuerdo con las teorías científicas vigentes, parece claro que, en la evolución de la protogallina a gallina, o de cualquier especie que evoluciona a otra nueva especie, ha de producirse un cambio genético. Lo que hace a la gallina ser gallina es la carga genética común que comparten todos los individuos de su especie (gallinas si son hembras, gallos si son machos, pero todos con unos genes gallináceos comunes). Según la teoría darwinista más simple (más bien neodarwinista, porque en tiempo de Darwin no se conocía el ADN), habría que pensar que este cambio en el material genético se produce por una mutación aleatoria, transmisible a la descendencia, que por la selección natural que se ejerce sobre las posteriores generaciones de gallinas acabará eliminándose si no conduce a ninguna ventaja adaptativa, o se asimilará al patrimonio genético de la especie en caso contrario.

Siguiendo esta idea, lo más lógico es que la mutación se produzca en las células reproductoras, para que los genes alterados puedan heredarse, lo que es una condición sine qua non. También sería posible que la mutación se produjera en los embriones, a medida que se desarrollan, pero siempre que esta mutación termine pasando a las células reproductoras; de otro modo, tendríamos un individuo mutado, pero cuya descendencia (si acaso el mutante fuera fértil) se compondría de perfectas protogallinas, y fin de la historia. Por un lado, el breve tiempo en el que crecen los embriones hace menos probable la segunda posibilidad, aunque por otro lado, al dividirse las células embrionarias a un ritmo elevado también son más altas las posibilidades de esa mutación aleatoria. Pero de un modo u otro, la mutación ha de acabar en las células heredables, que son las células sexuales. Antes de terminar el párrafo, recordemos un par de cosas importantes: las células sexuales son haploides, lo que significa que tienen n cromosomas, que al unirse a otra célula con n cromosomas durante la fecundación forman un embrión de 2n cromosomas, que luego se multiplicará formando más células con 2n cromosomas, llamadas diploides, que son las más abundantes. No obstante, el embrión en algún momento tiene también que formar algunas células reproductoras con la mitad de cromosomas, n, para transmitirlas a la descendencia, o bien, el embrion tiene que formar células generadoras de células sexuales en la edad adulta. Este interesante proceso —posiblemente no del todo bien conocido en algunas facetas, y en el que probablemente reside el meollo de la cuestión—, se denomina meiosis. Al menos en el hombre, y si no meto la pata, los óvulos —n cromosomas— se forman únicamente en la etapa de embrión, en número de unos 400, mientras que los espermatozoides —también n cromosomas— los generamos en gran número durante gran parte de la vida, lo que por cierto, multiplica las posibilidades de mutaciones en los mismos. Así que yo apostaría por los espermatozoides de los machos como principales proveedores de variabilidad genética, mientras que el óvulo, femenino y nutricio, corresponde al principio conservador (digamos que aporta el chasis y el motor que han demostrado su fiabilidad a lo largo de los eones, mientras que el espermatozoide se encarga de los accesorios y las mejoras técnicas puntuales, haciendo con todo esto una horrenda metáfora). Recordemos también, dicho sea de paso, que durante el proceso en el que los espermatozoides pasan al cuerpo de la hembra inyectados por órganos copuladores en el curso de un acoplamiento —dicho finamente— también hay un proceso de competencia y selección de los espermatozoides; ya sabéis, solo uno puede ganar la carrera.

De este modo, nuestra primera conclusión a la pregunta original de qué fue antes (huevo o gallina), sería que, probablemente, lo primero fue una protogallina fecundada por un gallo cuyo espermatozoide «ganador» estaba mutado, de cuyo huevo nacería la primera gallina. Es decir, que no podemos optar por huevo o gallina de modo claro y tajante, pero podemos explicar cómo ocurrió, que al final es lo que tiene contenido, lo sustancioso.

Sin embargo, volviendo a teorizar sobre la evolución, un planteamiento tan simple como el anterior no es plenamente satisfactorio y pone de manifiesto varios problemas. Si la evolución es así, simplemente aleatoria, las posibilidades de éxito evolutivo son muy pequeñas —podría aducirse que la evolución se produce en una escala de tiempo que no podemos imaginar adecuadamente, y al final es capaz de abrirse camino—. Sin embargo, no se han hallado fósiles de todos los «experimentos fallidos» de la naturaleza, que de actuar de un modo totalmente aleatorio, deberían haberse producido en un número considerable.

Además, hay caracteres genéticos que se pueden transmitir sin que se manifiesten. Recordemos que tenemos dos copias de cada gen, una que proviene de la madre y otra que viene del padre. Hay caracteres dominantes que se manifiestan con solo tener una copia, pero también los hay recesivos que requieren las dos copias para manifestarse. Otras veces, la cosa se queda a medias (recordemos la herencia mendeliana y todo aquello). Así que podría haber sido necesario esperar a varias generaciones después de la mutación protogallinácea para que, en un individuo dado, coincidiesen las dos copias del gen mutado, y muchas generaciones más para que ese gen (en caso de que resultase útil y, por tanto, fuese seleccionado) se extendiese en un número suficiente de individuos. Para acabar de rizar el rizo, y si no recuerdo mal cómo funciona el proceso de meiosis, hay una parte del material genético heredado que se pierde cada vez que se forma una célula sexual —en concreto, la mitad; lo correspondiente a n cromosomas, cumpliendo que n = 2n - n—. En este proceso, se remezclan y reparten fragmentos del ADN de los abuelos para hacer las células que potencialmente sirven para «hacer» nietos. Algo así como barajar las cartas antes de una nueva partida. Pero claro, esto implica que un 50% de las mutaciones, por muy interesantes que sean, se pierden por el camino, si no opera ningún mecanismo de selección genética durante la meiosis.

La realidad, pues, parece ser bastante más compleja que la idea de las «mutaciones aleatorias» sin más ni más. No hay que olvidar lo poco que se sabe, pese a todo lo que se habla de ello, sobre el ADN y sus funciones. La mayor parte del genoma humano no tiene función conocida (no codifica proteínas, y a veces se le ha denominado ADN «basura»). Se sospecha que puede intervenir en la regulación de la expresión genómica, y podría tener una importancia vital para poder entender cómo se produce la evolución de las especies.

Pese a lo arriesgado de la maniobra y a mis limitados conocimientos, voy a lanzar una hipótesis, para que pueda ser criticada por los lectores. En mi opinión, la aparición de una nueva especie no se produce de un modo totalmente abrupto (algo así como protogallinas que de repente empiezan a poner huevos de gallina, hasta que las primeras se extinguen y solo quedan las segundas), sino que se produce un «salto» genético más o menos gradual, iniciado por algún tipo de mutación, que se sigue de un fluir y refluir de los genes a través de varias generaciones de individuos, hasta que por selección se acaba estabilizando o se elimina. O sea, no una evolución individual, que acaba imponiéndose como especie independiente, sino una especie de «evolución en grupo» dentro de un conjunto de individuos relacionados. Intentaré aclararlo un poco más:

Pensemos en la aparición de gallinas (una especie nueva) por evolución de las protogallinas. Podemos pensar en dos posibilidades:

- Las nuevas gallinas son capaces de cruzarse con las protogallinas (o sea, la especie nueva y la vieja son interfértiles). En este caso, el nuevo material genético introducido en la especie preexistente se extenderá por ella y se seleccionará (se estabilizará y mantendrá si resulta útil para la adaptación, se eliminará en caso contrario). Al distribuirse el gen alterado en las generaciones siguientes, podrían aparecer individuos sin el gen (protogallinas puras), o con solo una copia del mismo (procedente del padre o de la madre), o con ambas copias. Con el tiempo, y si el nuevo gen es útil, los individuos con las dos copias del gen acaban imponiéndose como nueva especie (al menos, en el espacio ecológico donde ese nuevo gen resulta beneficioso).

- La especie nueva no puede cruzarse con la vieja. Esto suele ocurrir cuando el número de cromosomas varía. Si no me equivoco, este es el caso de los primates superiores y el hombre, en el que, en algún momento de la evolución humana, dos cromosomas de simio se fusionaron en uno. En este caso, la aparición de un único individuo mutado no es suficiente, ya que este se extinguiría sin descendencia. Es necesario que la alteración (que casi siempre será cromosómica) se dé con cierta frecuencia en esa especie, para alcanzar cierto procentaje de la población con esa alteración. Este tipo de procesos son posibles: pensemos en la trisomía del par 23 en humanos, que produce el síndrome de Down, con unas consecuencias bastante bien definidas (o sea, que no pueden obedecer a una alteración aleatoria). Existen otros síndromes de este tipo, que corresponden a alteraciones en el número de cromosomas. Aún la cosa se puede complicar más, aunque en este caso el hombre —al menos, en la actualidad— no participa en ello: algunas especies con distinto número de cromosomas sí son interfértiles, y generan híbridos. Un caso típico de híbridos es el de las mulas y los burdéganos. Estos animales tienen un número de cromosomas 2n impar, por lo que no pueden dividirse convenientemente para tener descendencia. Sin embargo, aunque no puedan reproducirse, existen, y están sujetos a alteraciones genéticas. En algún momento, podría surgir un nuevo tipo de mula que fuera fértil, bien con otra mula, o con un burdégano, o con un caballo, o con un asno. De este modo, la evolución daría otro pequeño salto.

Este último caso, ilustra cómo la evolución podría no estar marcada únicamente por el carácter aleatorio de las mutaciones, y que ciertas alteraciones puedan ser más frecuentes que otras. La hibridación, especialmente, es un ejemplo de cómo la evolución puede estar de algún modo dirigida: al hibridar el material genético de dos especies, el resultado de tal «asociación» suele ser mejor que cualquiera de los progenitores por separado (acabo de leer que las mulas son más listas que caballos y asnos).

Bueno, espero no haber metido mucho la pata (o sea, no toméis al pié de la letra todo lo que he dicho). Además, hay muchas lagunas en los conocimientos actuales (por supuesto, me refiero a los conocimientos de verdad, y no a deleznables zarandajas creacionistas o semejantes). Para los que quieran informació seria y fiable, aquí van los links de la Wikipedia sobre evolución, especiación y neodarwinismo. Al menos espero haber transmitido la idea de que la evolución es una cosa muy seria y compleja, sobre la que sabemos mucho, pero desconocemos aún más. Así que abandonemos cualquier aspiración de dar una respuesta simple y taxativa a preguntas como «¿qué fue antes, el huevo o la gallina?»

Alberto Soldevilla

Categorías: Biología, Ciencia

Publicado por

AITRi

en

6:55 p. m.

18

comentarios

![]()

La estructura de las proteínas

La secuenciación del genoma humano, aún siendo un hito en la historia humana, sólo encontrará verdadero significado cuando se puedan convertir las secuencias génicas en secuencias y estructuras de proteínas. Esto permitirá desentrañar el origen del desarrollo de un organismo con la formación de partes que no están presentes como tales en el embrión. Este desarrollo se produce en niveles sucesivos: el plegamiento de las secuencias de aminoácidos para formar estructuras globulares, las interacciones entre proteínas y otros componentes para formar orgánulos celulares, la interacción entre células para formar órganos y seres vivos. El principio de todas estas estructuras se halla escondido en las secuencias de aminoácidos. En un sentido muy concreto, el sentido de la vida debe buscarse en este nivel de organización química, en particular en la relación existente entre la estructura lineal de la proteína y la estructura tridimensional (también conocida como estructura nativa) presente en los seres vivos.

El conocimiento de los mecanismos en que se basa el plegamiento permitiría predecir la estructura nativa a partir de la secuencia de sus aminoácidos. Desafortunadamente, aún no es posible predecir de forma general la estructura (y función) de una proteína a partir de su secuencia lineal. Sin embargo, sí se ha encontrado solución al problema inverso, es decir, dada una estructura nativa, podemos averiguar la secuencia lineal de los aminoácidos que la componen. Un paso más en el conocimiento de los mecanismos que hacen funcionar a los seres vivos.

Publicado por

AITRi

en

9:46 a. m.

3

comentarios

![]()

martes, junio 06, 2006

La brújula

Todo el mundo sabe qué es una brújula. Un artilugio que contiene una aguja imantada que siempre marca el norte. Durante siglos fue un instrumento imprescindible en la navegación y todavía hoy puede sernos muy útil si somos aficionados a caminar por el monte.

Es probable que muchos lectores conozcan su origen. Como la imprenta o la pólvora, fue inventada por los chinos y traída a Europa por los árabes. Por ejemplo, ya en el siglo XIII era de uso común entre los marinos del mediterráneo que echaban agujas imantadas en recipientes con agua para conocer la dirección norte-sur.

Pero, ¿alguien puede decir por qué la obstinada aguja de la brújula se empeña en mirar siempre al norte? La respuesta es que se alinea con las líneas de fuerza del campo magnético terrestre.

El núcleo de La Tierra está compuesto de hierro en casi un 80%. Debido al enorme calor del interior de nuestro planeta, este hierro permanece fundido y en continuo movimiento. El flujo de metal líquido genera una serie de campos eléctricos que a su vez crean campos magnéticos. Así, se puede decir que el núcleo terrestre es una dinamo a escala gigantesca.

Terminaremos diciendo que no solamente los humanos nos servimos del campo magnético terrestre. Muchos animales lo utilizan como sistema natural de orientación en sus viajes migratorios. Y todavía más importante, actúa como un enorme escudo que protege a todos los seres vivos de las partículas cósmicas que bombardean constantemente nuestro planeta.

David Sucunza

Categoría: Geología

Publicado por

AITRi

en

10:05 a. m.

4

comentarios

![]()

viernes, junio 02, 2006

Sorpresas en nuestro genoma

“Es un libro de historia, una narración del viaje de nuestra especie a lo largo del tiempo. Es un manual de uso, con información increiblemente detallada para la construcción de cada célula humana. Y es un revolucionario libro de texto de medicina, con señales que facilitarán una inmensa cantidad de nuevas armas para tratar, prevenir y curar enfermedades.” El autor de esta definición del genoma humano es Francis Collins, director del Consorcio Internacional que consiguió su secuenciación. Fue en 2001 y desde entonces este manual del ser humano no ha parado de dar sorpresas.

El libro biológico que es el genoma está escrito en el lenguaje químico de la doble cadena del ácido desoxirribonucleico (ADN). Como todas las cadenas, el ADN está formado por eslabones: los nucleótidos, moléculas orgánicas de pequeño tamaño que vienen a ser las letras de este idioma. En este alfabeto químico hay cuatro letras distintas, según la base nitrogenada -adenina, timina, guanina o citosina- que esté incluida en el nucleótido, que a lo largo del libro del genoma van formando frases: los genes. La información que contienen estas frases se traduce en forma de proteínas, que son las encargadas de ordenar la realización de los distintos procesos biológicos que conforman la vida. Cuando una célula va a dividirse, todo el genoma se empaqueta en cromosomas -23 pares en el ser humano-. Por tanto, y siguiendo con la analogía, podríamos decir que nuestro libro se divide en 23 capítulos.

Antes de conseguir la secuenciación de los 3.000 millones de pares de bases que forman el genoma humano, se pensaba que contendría alrededor de 100.000 genes. El asombro fue mayúsculo cuando, tras el primer borrador, hubo que bajar este cálculo a una cifra entre 30.000 y 40.000. Craig Venter, presidente de Celera Genomics, dijo en aquel momento “esto prueba lo poco que comprendíamos antes de él”. Hoy en día la estimación es incluso menor y los últimos cálculos rondan los 22.000 genes, lo que supone tan solo el 1.5% de nuestro material genético. El 98.5% restante está formado por regiones reguladoras, que sirven para encender, acelerar o frenar la transcripción de los genes, restos de genes antaño funcionales y una gran cantidad de material, hasta un 90% del total, sin función conocida y al que en ocasiones se le ha denominado “ADN basura”. Sin embargo, no parece lógico pensar que la vida despilfarre un 90% de nuestro código genético en regiones sin valor y de hecho ENCODE, un nuevo proyecto del consorcio público que está catalogando todos los elementos con actividad biológica presentes en el genoma, anunció recientemente que ha encontrado “fuertes evidencias de que otras partes tienen funciones importantes, aunque hay muy poca información sobre dónde están y cómo trabajan estos elementos funcionales”.

Otro gran problema al que se enfrentan los científicos es que, conforme más se conoce acerca de nuestro genoma, está menos claro el concepto de gen. Hasta no hace mucho un dogma de la biología decía “cada gen codifica una sola proteína”. Sin embargo, hoy se sabe que hay genes que traducen muchas proteínas distintas e, incluso, se ha observado que pueden interaccionar entre sí afectando el resultado de la transcripción.

David Sucunza

Categoría: Biología

Publicado por

AITRi

en

9:43 a. m.

1 comentarios

![]()

miércoles, mayo 31, 2006

La lluvia ácida

Hoy en día, nuestra sociedad se colapsaría sin el consumo ingente de los combustibles fósiles carbón, petróleo y gas natural. Sin embargo, este uso abusivo provoca graves problemas medioambientales como el efecto invernadero o la lluvia ácida.

¿En que consiste esta lluvia ácida? Los combustibles fósiles, que están formados por carbono e hidrógeno, contienen también impurezas de otros elementos como azufre o nitrógeno. Cuando quemamos estos combustibles para obtener energía, el proceso químico que se produce es una oxidación y los compuestos que se derivan de ella se denominan óxidos. Una vez expulsados a la atmósfera, los óxidos resultantes de las impurezas de azufre y nitrógeno se combinan con vapor de agua dando lugar a ácidos, como el nítrico o el sulfúrico, que más tarde se precipitan en la tierra en forma de lluvia. Esta lluvia corrosiva degrada todo lo que toca y así, ha destruido enormes extensiones de bosques y tierra de cultivo, diezmado la vida de los lagos de agua dulce y cada año causa pérdidas de cientos de millones de euros por daños a construcciones y monumentos en todo el mundo.

¿Cómo podemos evitar la lluvia ácida? Sólo hay un camino, un ritmo de vida que suponga un uso más racional de la energía.

David SucunzaCategoría: Química

Publicado por

AITRi

en

9:53 a. m.

7

comentarios

![]()

jueves, mayo 25, 2006

Computación cuántica

Ayer se conoció el nombre del nuevo galardonado con el premio Príncipe de Asturias de Investigación. El premio recayó este año en el español Ignacio Cirac, que dirige el Instituto Max Planck de Óptica Cúantica en Garching. Además de ciertos detalles significativos, como ser el científico más joven en recibir este galardón o que su candidatura estuviera avalada por seis premios Nóbel, resulta interesante el hecho de que se haya premiado un estudio básico, donde la aplicación técnica (aunque posible y muy útil) es aún muy lejana.

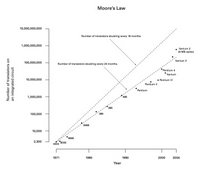

Los ordenadores actuales, basados en chips de silicio, han ido aumentado su capacidad a lo largo de los años de forma constante. Se ha reducido su tamaño a la vez que se mejoraban sus prestaciones, su velocidad, su potencia. Sin embargo, esta evolución tiene un límite físico, pronosticado por

Categoría: Física

Publicado por

AITRi

en

1:07 p. m.

2

comentarios

![]()

miércoles, mayo 24, 2006

Agenda para el diseño de una política científica solidaria

"Las variaciones de la ciencia dependen de las variaciones de las necesidades humanas,y los hombres de ciencia suelen trabajar, queriéndolo o sin quererlo, a sabiendas o no, al servicio de los poderosos o al del pueblo que les pide confirmación de sus anhelos".

Miguel de UNAMUNO,

Del sentimiento trágico de la vida, Madrid, Aguilar, 1987, p. 28

La reciente manifestación del colectivo "Precarios", el pasado 20 de mayo en Madrid, ha revelado la potencia del movimiento de los jóvenes investigadores, reconocido como interlocutor por el Gobierno a escala nacional y cada vez con mayor repercusión mediática. Pero también demuestra lo limitado, hoy por hoy, de los planteamientos de los becarios, cuando se trata de salir de las reivindicaciones puramente laborales (por otra parte, indiscutibles, y el motivo de que surgiera la organización).

En el Manifiesto por la investigación, además de la tradicional exigencia de derechos laborales para los investigadores, que en realidad hacen, de modo encubierto, un trabajo altamente cualificado y productivo, se proponen también medidas que afectan a los propios programas y planes de "diseño de una política científica" del Gobierno: que se invierta más en investigación y que se dé estabilidad a quienes se dedican a ella, creando más oportunidades de disfrutar de una carrera investigadora completa y sin sobresaltos. Estoy de acuerdo.

Ahora bien, y aquí viene lo que considero reprochable, los argumentos para exigir tales demandas se basan en criterios económicos: se comienza subrayando que "la producción investigadora (...) forma parte de la base fundamental que proporciona el desarrollo económico, social y cultural de un país de cara al futuro" (el subrayado es mío; nótese que la alusión al interés nacional tiene un contenido excluyente); a renglón seguido se añade que "la investigación no es un gasto, sino una inversión rentable"; y la petición de que se conceda más relevancia a la investigación básica (en gran parte, la científica teórica, incluyendo también aquí el manifiesto, de modo expreso, la humanista) se hace aduciendo que en ésta es en la que se apoya la "investigación tecnológica con rendimientos a corto plazo", y, por tanto, produce "rendimientos a largo plazo"; eso sin contar las referencias a la pérdida de dinero del Estado generada por la huida de becarios, bien al extranjero o para realizar actividades más lucrativas y menos precarias.

Me doy cuenta de que este lenguaje economicista es el que entienden los políticos, los medios de comunicación y los consumidores (antaño la categoría conocida como ciudadanos). Todos quieren dividendos y rentabilidad en la inversión. Y que al asumir este lenguaje  nosotros.

nosotros.

Creo que los investigadores debemos rechazar esta lógica perversa, hacia la que nos deslizamos, de modo inconsciente (o al menos eso quiero pensar), al asumir la neolengua nacional-economicista para expresar nuestras demandas. Si hablamos en términos de competencia económica, contribuimos a reforzar el predominio de tales valores en la sociedad y la privatización del conocimiento.

Hay otra forma de hacer que se reconozca el trabajo de los investigadores como algo valioso e imprescindible: en lugar de subrayar el carácter de mercancía que, hoy por hoy, ya se le da a nuestra vocación, precisamente nuestra labor debe consistir en darle la vuelta a tal noción, y exigir el uso cívico y solidario del conocimiento generado gracias al apoyo público (y que de otro modo sería mucho más dificultoso producir). Es decir: hay que desvincular la investigación, la producción de conocimiento, un factor positivo a priori, del uso del conocimiento, éste sí perjudicial o benéfico, un tema que todavía no ha sido sometido a debate entre los investigadores, y en el que hasta ahora venimos actuando, cegados por la urgencia de justificar la dotación presupuestaria (nuestros propios ingresos), de un modo que refuerza el sistema dominante: éticamente reprochable y orientado a perpetuar los privilegios y la pobreza correlativa a ellos.

Aunque los "rendimientos a corto plazo" sean menores, propongo plantear las reivindicaciones respecto al "diseño de la política científica" desde el punto de vista de la utilidad social (es decir, humana) de la investigación, no sólo en un país, o en Occidente, sino a escala planetaria. Si la investigación crea bienestar, que no sea de modo comparativo y excluyente, reforzando la primacía de unos, que disfrutan de sus resultados, frente a otros, que padecen su falta de talento (ya se sabe, los pobres tienden a ser más torpes, y a merecer su miseria, así como la de sus hijos y nietos). Que se aproveche la investigación para promover la solidaridad y la cooperación. Si conseguimos que la sociedad se plantee estos valores, que los considere, que incluso llegue a asumirlos como propios, obtendremos grandes "rendimientos a largo plazo". Y, en todo caso, nos quedará la satisfacción moral de no contribuir al triunfo del cinismo imperante, el darwinismo social salvaje que bajo palabras edulcoradas disfraza de efectividad el refuerzo de las desigualdades de partida, el dominio a través de la violencia (no hay propiedad sin sus guardianes) y el expolio.

Esta es al menos mi propuesta de agenda, que sólo pretende ser un esbozo de orden del día, cuyos puntos hay que trazar, con calma y de modo mancomunado, entre todos los investigadores que creen que su trabajo sólo tiene sentido si cumple una función social y aspiran a hacer suyo el ideal del científico consagrado al bienestar de la humanidad. Manes de Einstein, os invoco.

Jesús Ruiz Pérez

http://www.terra.es/personal2

Publicado por

AITRi

en

10:01 a. m.

1 comentarios

![]()

miércoles, mayo 17, 2006

La forja de un genio

[Emitido en el espacio "Divulgación Científica" de RNE 5 Todo Noticias - La Rioja]

Santiago Ramón y Cajal nació en la localidad zaragozana de Petilla de Aragón en 1852.

El tesón de este aragonés le convirtió en el primer español en conseguir el Premio Nóbel hace exactamente 100 años.

El joven Ramón y Cajal estudió medicina en Zaragoza . Acabados sus estudios, decidió presentarse a las oposiciones de médico militar y pasó a ser capitán con destino en Cuba, de donde la guerra, el paludismo y otras circunstancias le hicieron regresar en 1875. Reincorporado a la vida académica como profesor de Anatomía comenzó a investigar para su doctorado.

Fue director del Museo Anatómico de Zaragoza, catedrático de Anatomía de

En 1892 consiguió la cátedra de Histología en Madrid y dos años más tarde fue reconocido con el primer título en el extranjero de

José Ignacio Barriobero

Categoría: Medicina, Historia

Publicado por

AITRi

en

1:37 p. m.

2

comentarios

![]()

lunes, mayo 15, 2006

Ciencia para I... (II)

Saludos de nuevo; es lo malo que tienen las prisas, que uno se deja cosas por decir y no aclara lo suficiente lo que escribe. Pero tras un poco de reflexión y con la ayuda de los comentarios, verbales y escritos, creo que podré arrojar un poco de luz sobre las dos (eran dos, sí) ideas de mi anterior post:

- Ciencia para científicos: la idea era (y sigue siendo) aportar un nuevo punto de vista para las entradas de esta bitácora, esto es, que se incluyesen algunas dirigidas a los propios científicos, que habitualmente «están pez» en lo que no corresponde a su esfera de conocimiento. A esto se puede alegar que el científico, en cuanto que ignorante en un tema dado, está en el mismo nivel que el no-científico, y por tanto no hay nada especial que añadir a lo que hay. Sin embargo, creo que de los científicos se puede esperar algo menos de impaciencia, ya que el Conocimiento (así, con mayúscula) no debe ser en el científico una mera cuestión de curiosidad que haya que satisfacer rápidamente para no perder la atención del lector, sino más bien una obligación, bien moral, bien creada por la necesidad de ampliar los horizontes del propio campo de conocimiento, integrando elementos (herramientas, técnicas, resultados) de otras áreas de la ciencia. Aunque claro, esta tarea podría justificar el hacer una nueva bitácora, e incluso varias más... Es solo una sugerencia. Al menos, pienso que el sector más libertario de este blog estará de acuerdo con la visión de la ciencia que pretendo dar aquí, la evolución a través de la simbiosis, en lugar de a través de la competencia.

- Química y Tipografía: ciertamente, este tema se sale un tanto de este espacio, así que no he encontrado mejor solución (parafraseando al adorable robot Bender) que... ¡hacer mi propio blog! ¡Con casinos... y furcias! Así que a él me remito: lo he bautizado «Tipoquímica», y se puede visitar en esta dirección: http://tipoquimica.wordpress

.com (espero que en adelante sea considerado como un blog amigo de éste).

Publicado por

AITRi

en

1:19 p. m.

1 comentarios

![]()

jueves, mayo 11, 2006

III Certamen TERESA PINILLOS de divulgación científica

La Asociación de Investigadores y Tecnólogos de La Rioja (AITRi) ha organizado junto con la Universidad de La Rioja, el III Certamen de Ensayos de Divulgación Científica "Teresa Pinillos".

Los interesados en participar deben presentar un ensayo redactado en castellano con una extensión máxima de 2.000 palabras y que verse sobre cualquier campo de la actividad científica, de la humanístico-social a la científico-técnica.

Los originales deben presentarse antes del 15 de julio de 2006 mediante el sistema de plica: cinco copias del trabajo en papel (DIN A4, Times, 1,5 interlineado) más un disquete con el documento en formato word o texto (.txt) y un sobre con los datos personales del autor o autores en el interior (nombre, apellidos, dirección postal y de correo electrónico, teléfono) y el seudónimo en el exterior.

Toda esta documentación debe incluirse en un sobre en cuyo exterior no figuren los datos del autor para enviarla, con la referencia "III CERTAMEN TERESA PINILLOS DE ENSAYOS DE DIVULGACIÓN CIENTÍFICA AITRI-UR", a Universidad de La Rioja. Edificio Vives, Despacho 237, c/ Luis de Ulloa s/n, 26004, Logroño, La Rioja.

El fallo del jurado, compuesto por investigadores de la Universidad de La Rioja y representantes del tejido socioeconómico, se dará a conocer antes del 6 de octubre de 2006. El primer premio está dotado con 500 euros y los dos accésit, con 300 euros cada uno. El jurado valorará la capacidad divulgativa, la calidad literaria y el interés social del ensayo.

El derecho de reproducción de los ensayos premiados pasará a ser de la Universidad de La Rioja, quien en función de la cantidad y calidad de los mismos, podrá decidir su publicación en un libro recopilatorio.

En su tercera edición, el Certamen de Ensayos de Divulgación Científica Teresa Pinillos pretende aproximar la ciencia a la sociedad de manera que por una parte, el científico pueda hablar de su trabajo en un lenguaje didáctico y por otra, la propia sociedad manifieste su percepción de la ciencia o de determinados temas científicos.

Temática del Certamen

El certamen está abierto a todos los campos del conocimiento desde las ciencias experimentales hasta las sociales y humanas. Los trabajos pueden versar desde distintos temas científicos con un atractivo divulgativo marcado hasta el análisis crítico de la situación actual de la ciencia o los científicos. Los participantes podrán presentar un máximo de dos trabajos.

Se puede consultar los trabajos premiados en ediciones anteriores en: www.unirioja.es/aitri

José Ignacio Barriobero

Publicado por

AITRi

en

6:14 p. m.

1 comentarios

![]()

miércoles, mayo 10, 2006

V de bruja

[Emitido en el espacio "Divulgación Científica" de RNE 5 Todo Noticias - La Rioja]

La película “V de vendetta”, ahora en las salas de cine, vuelve sobre un tema clásico en la política-ficción: el Gobierno pretende consolidar su poder fomentando entre la población el miedo a un enemigo interno que, en realidad, no existe. En este caso la amenaza de atentados terroristas con armas bacteriológicas sirve para justificar una dictadura totalitaria cristiana, un argumento que alude, con bastante claridad, a la guerra de Irak y la “lucha contra el terror”.

Sólo los paranoicos ven una conspiración en cada esquina. Pero “haberlas, hailas”. A lo largo de la historia no han faltado ocasiones en las que el poder ha demonizado a grupos étnicos, sociales o religiosos para convertirlos en “chivos expiatorios”. Así lo atestigua el fenómeno de la caza de brujas, desarrollada en toda Europa, desde los inicios del Renacimiento, a lo largo de tres siglos.

En la primera parte de su Historia nocturna1, Carlo Ginzburg explica cómo primero se ensayó la persecución contra los leprosos, los mendigos y los judíos, candidatos ideales al odio, a los que se acusó de conspirar contra sus vecinos. Después se escogió otro objetivo: una escurridiza secta de adoradores de Satán.

Sí que existían, entonces como ahora, las brujas y los curanderos, pero eran figuras aisladas. La aportación de los inquisidores fue inventar el aquelarre, una reunión nocturna con el diablo, de modo que transformaron la brujería real en otra cosa: una dañina organización secreta. El propio procedimiento inquisitorial, que consistía en torturar al acusado para que delatara a sus compañeros, favorecía a su vez las denuncias en cadena y la multiplicación de las detenciones.

1. Carlo GINZBURG, Historia nocturna, Península, Barcelona, 2003.

Publicado por

AITRi

en

1:19 p. m.

2

comentarios

![]()

lunes, mayo 08, 2006

Ciencia para I...

Como esta idea perfila una labor de ingentes proporciones, voy a dejarla aquí a la espera de los (posibles) comentarios, sean de apoyo o en forma de lluvia de críticas o aún peor, silencio. Pero para sentar un precedente, quiero adelantar la que será mi humilde aportación, si todo sale bien. Aunando mi trabajo (Química) con una de mis caprichosas aficiones (Tipografía), voy a intentar escribir una breve guía sobre la composición de textos de química. (Como quizá algunos hayan adivinado ya, me refiero a usar (La)TeX para escribir textos de química. En mis búsquedas, no he encontrado nada parecido, ni siquiera en inglés, así que creo que ha lugar.) Si tengo éxito, el escrito verá la luz por entre los bytes de esta bitácora. Por supuesto, se admiten sugerencias y peticiones. Para abrir boca, allá va un ejemplo de lo que podría ser tal guía, que en este caso versa sobre Botánica: está disponible en la página del Grupo de Usuarios de TeX Hispanohablantes (CervanTeX), en concreto en el número 6 (pdf) de su revista «TeXemplares», bajo el título «LaTeX, Linux y la Botánica: una excelente combinación» (Páginas 27-40. También hay otros artículos interesantes en el mismo número.) Veamos cómo evoluciona la idea.

Categoría: Ciencia, Química

Publicado por

AITRi

en

5:22 p. m.

1 comentarios

![]()

¿El huevo o la gallina?

¿Qué fue antes, el huevo o la gallina? Solemos usar esta pregunta para dar a entender que algo, por lo normal el origen de una situación, constituye un problema insoluble. A continuación propongo a los navegantes plantear el dilema del huevo o la gallina como un acertijo. Porque tiene una respuesta rigurosamente científica.

De acuerdo con la teoría de la evolución, cada nueva especie es la transformación de una especie anterior. Antes que la gallina que todos conocemos existía otro tipo de ave parecido a la gallina, pero que no era una gallina todavía, dado que le faltaba alguna característica peculiar propia de las gallinas. En un momento dado una de estas no-gallinas puso el huevo de la primera gallina, surgida genéticamente como fruto de un lento proceso de selección y cruce entre aquellas no-gallinas mejor adaptadas a las condiciones del medio. Por lo tanto, no hay misterio: lo primero fue el huevo, un huevo de no-gallina con un polluelo de gallina en su interior. Al menos eso es lo que nos permiten afirmar nuestras observaciones de la vida en la naturaleza.

(Deseo expresar aquí mi agradecimiento a Juan Manuel Soto Juárez, que fue quien me planteó este acertijo en la lejana época en la que ambos estudiábamos Física en Zaragoza.)

Categoría: Ciencia

Publicado por

AITRi

en

1:33 p. m.

3

comentarios

![]()

viernes, mayo 05, 2006

El agujero de ozono... ¿se cierra?

La reducción de la capa de ozono que protege a la Tierra se debe a la acción química del cloro y el bromo liberados por los compuestos clorofluorocarbonados (CFCs), producidos por el hombre y que se utilizan en atomizadores de aerosol y equipos de refrigeración. Debido a las evidencias del descenso en los niveles de ozono en la atmósfera de las latitudes medias del planeta y el agujero generado en la Antártida se debían a la acción humana, los productos químicos que afectan a la capa de ozono fueron prohibidos con la firma del Protocolo de Montreal de 1987, que hasta ahora ha sido ratificado por 180 países. El adelgazamiento de la capa de ozono, que absorbe la mayoría de los perjudiciales rayos ultravioleta del sol, eleva los riesgos de cáncer en la piel y de cataratas en los humanos y podría además dañar los campos de cultivos y la vida marina.

Los autores del artículo, los doctores Weatherhead (Univeridad de Colorado) y Anderson (Instituto Meteorológico Danés), analizaron información recopilada a través de los satélites y estaciones en La Tierra y los datos procedentes de 14 modelos computacionales. Los científicos descubrieron que los niveles de ozono se han estabilizado o que se han incrementado levemente en los últimos 10 años. Sin embargo, una recuperación completa, si se produce, todavía podría tardar décadas. Los cambios de temperatura, los gases de efecto invernadero, el óxido nitroso y la dinámica de la atmósfera, factores que pueden modificar los niveles de ozono, influirán decisivamente en los valores futuros. La actividad volcánica en la Tierra también tiene un impacto. Por ejemplo, la explosión de 1993 del Monte Danubio en Filipinas provocó que los niveles en la capa de ozono mostraran un retroceso en varios años.

Queda aún por aclarar si estos incrementos son temporales o realmente el Protocolo de Montreal está surtiendo efecto.

Diego Sampedro

Categoría : Noticias, Ciencia

Publicado por

AITRi

en

5:29 p. m.

3

comentarios

![]()

La Química y la cocina

(El siguiente texto ha sido emitido en RNE 5 "Todo Noticias")

Todos los cocineros son químicos –aunque muchos no lo sepan– y todos los químicos son cocineros, aunque también lo desconozcan. De hecho, la química empezó en la cocina y las primeras reacciones químicas se produjeron, asando alimentos, cociéndolos, mezclándolos, haciendo emulsiones, sazonándolos, friéndolos, filtrándolos, espesando salsas y destilando líquidos, llegando incluso a dominar empíricamente algunas operaciones bioquímicas, como la fermentación para producir vino, cerveza y miles de clases de quesos y panes.

Los primeros aparatos y operaciones de los alquimistas se tomaron prestados de la cocina, y las ollas, los peroles, los alambiques, los morteros, los hornos y las grandes cucharas para revolver las mezclas fueron los instrumentos con los que se comenzó a trabajar con el mercurio, el azufre, el carbón y toda clase de mejunjes en búsqueda de recetas para producir oro, la piedra filosofal y la eterna juventud.

Estos aparatos y procedimientos se fueron modificando poco a poco y algunos se devolvieron a la cocina notablemente mejorados, siendo quizás los ejemplos más clásicos el de la olla a presión –que permite cocinar a temperaturas más altas que con el agua o el aceite- y el “baño maría”, que todo cocinero conoce y que se debe a la alquimista “María la Judía”, así llamada porque el gran alquimista Zoísmo se refería a ella diciendo que era hermana de Moisés, pues podía calentar a 100 grados los alimentos sin que se mezclasen con el agua.

Pero la química sobre todo aportó a la cocina el conocimiento del por qué de las cosas y cuál es la influencia de los diferentes ingredientes y operaciones en el resultado final de un buen plato.

José Ignacio Barriobero

Categoría: Química

Publicado por

AITRi

en

9:50 a. m.

8

comentarios

![]()

jueves, mayo 04, 2006

¿A qué se deben los terremotos?

(El siguiente texto ha sido emitido en RNE 5 "Todo Noticias")

La superficie de

El movimiento de estas placas es muy lento, en el intervalo de una vida humana no supera el centímetro, pero considerando el transcurso del tiempo a escala geológica pueden llegar a recorrer miles de kilómetros. En este desplazamiento, las placas colisionan y se arrugan como los pliegues de una tela dando lugar a nuevas montañas y cordilleras. Así, el Himalaya surgió hace unos cincuenta millones de años cuando la India y Asia, que anteriormente estuvieron separadas por un enorme océano, chocaron entre sí.

Los terremotos tienen la misma causa. Las fricciones entre las placas tectónicas van acumulando tensiones mecánicas que en un momento dado acaban por descargar originando los temidos temblores de tierra.

David Sucunza

Categoría: Geología

Publicado por

AITRi

en

10:35 a. m.

5

comentarios

![]()

miércoles, mayo 03, 2006

La imprenta y su impacto en la cultura europea

En el devenir de la historia, varios momentos han sido fundamentales para el desarrollo de la cultura europea. Probablemente el más importante de todos ellos haya sido el siglo XV, el siglo del Renacimiento. Diversos acontecimientos contibuyeron al cambio de mentalidad que fue su origen. Por un lado, el declive del imperio bizantino, que desaperecía en 1453 con la conquista de Constantinopla por los turcos, motivó que muchos eruditos grecoparlantes huyeran hacia el oeste, principalmente a Italia, llevando consigo gran número de documentos que sirvieron para el redescubrimiento del arte y la cultura clásica. Por otra parte, el despoblamiento que sufrió el continente debido a las epidemias de peste del siglo XIV provocó la subida de los salarios de los trabajadores y favoreció la invención de tecnología que pudiera sustituir a la mano de obra. A su vez, los adelantos técnicos fueron fuente de nuevos descubrimientos que transformaron la sociedad europea. Entre ellos se pueden destacar los viajes oceánicos, que llevaron al descubrimiento de nuevos continentes, y la invención de la imprenta, que permitió la rápida transmisión de conocimientos.

En la Edad Media el saber había quedado recluido a las bibliotecas de los centros religiosos. Allí, los monjes copiaban a mano obras clásicas y religiosas en pergaminos elaborados con piel de res lo que les permitía controlar que obras eran difundidas y cuales quedaban en el olvido. El alto coste de los libros los hacía piezas raras, la biblioteca del Papado en el palacio de Aviñón que fue una de las mas completas en el siglo XIV sólo llegó a reunir unos 2.000 códices, y eran muy pocos los personaje que dada su elevada posición económica y social podían adquirirlos. Así, los libros tenían un sentido comunitario. Por ejemplo, los libros de coros medievales están escritos en grandes caracteres ya que se leían en grupo. También era común en los conventos las lecturas en voz alta durante las horas de comida o recogimiento.

A finales de la Edad Media, mientras en los conventos se iba abandonando la dura tarea de copista en beneficio de una vida más comoda, las primeras universidades y la burguesía urbana, con un mayor desahogo económico, demandaban más libros. La primera actividad relacionada con su manufactura que salió del ámbito religioso fue la encuadernación. Por otra parte, desde el siglo XII se conocía en Europa el papel pero no se pudo fabricar en gran cantidad hasta el desarrollo del molino de mazos alternantes. El papel era necesario para la imprenta cuyo primer ejemplo fue la xilografía. Esta técnica, que como el papel fue inventada en China, consiste en el grabado del inverso de un texto o dibujo en una plancha de madera dura que posteriormente es usada para imprimir varias hojas de papel. Sin embargo, la xilografía es una labor muy dura y costosa y la madera no soporta un uso prolongado en la prensa.

La aportación fundamental para el desarrollo de la imprenta fue el uso de tipos móviles que pudieran juntarse para un trabajo y volver a separarse posteriormente. Esta fue la gran idea que tuvo Johannes Gutenberg, que trabajaba como orfebre y artesano en Maguncia, alrededor del año 1440. Pero con anterioridad ya habían existido precedentes de esta invención. En la China del siglo XII, el alquimista Bi Sheng fabricó por primera vez tipos móviles de madera pero el gran número de signos que componen el alfabeto chino hizo que el invento no tuviera éxito y cayera en el olvido. Por otro lado, los encuadernadores europeos del siglo XV también utilizaban un sistema de tipos sueltos para grabar las portadas de piel y que venían a ser unos hierros con caracteres invertidos parecidos a los que se usan para marcar ganado. De hecho, Gutenberg no fue el único que tuvo la idea de los tipos móviles en su época y en similares fechas otro artesano, Lauren Janszoon Coster, diseñó en Holanda un prototipo similar aunque menos práctico.

Para desarrollar su idea con carácter de negocio empresarial, Gutenberg se asoció con un acaudalado platero, Johann Fust. Pronto advirtieron que la vida de los tipos de madera en las viejas prensas de vino que utilizaban era demasiado limitada por lo que comenzaron a hacerlos de metal, primero de plomo y luego en una aleación de éste con estaño y antimonio. El primer libro impreso en el taller de Gutenberg fue la Biblia de 42 líneas, que tuvo una tirada de 180 ejemplares, estaba formada por más de 1200 páginas y utilizaba la letra gótica. Siguiendo este ejemplo, las primeros libros impresos fueron obras religiosas y tenían un terminado lo más parecido posible a los escritos a mano. Así, la posición de mayúscula al inicio de capítulo quedaba sin imprimir para que fuera posteriormente dibujada a mano.

En 1462, Maguncia fue saqueada por las tropas del conde Adolfo de Nassau lo que llevó a la mayoría de los impresores a huir de la ciudad y extenderse por toda Europa llevando su oficio consigo. Muchos tuvieron como destino Italia donde la manufactura del libro artesanal religioso estaba más desarrollada que en Alemania. Allí, los impresores entraron en contacto con las ideas renacentistas y comenzaron a componer libros de autores clásicos griegos y romanos. En esta labor destacó Aldus Manuncio, el más importante prototipógrafo después de Gutenberg. Desde su taller en Venecia comenzó a editar libros de menor tamaño, con un formato de octavo, que los hacía más baratos y manejables y fue éste un paso fundamental que permitió una difusión más amplia de la cultura humanística.

Al inicio del siglo XVI, la imprenta ya era una industria generalizada en Europa, por ejemplo en Venecia existían más de 400 imprentas, y se había convertido en un arma fundamental para transmitir el conocimiento y las nuevas ideas. Así, el texto impreso fue esencial para divulgar la Reforma emprendida contra la jerarquía eclesiástica. Además de emitir miles de panfletos con sus ideas, Lutero publicó en 1534 la Biblia traducida al alemán, en lo que se convirtió en el primer libro de circulación masiva de la historia. Poco después, y al tomar conciencia de la fuerza de la imprenta, la contrareforma instauró la censura para luchar contra el poder democratizador del libro.

El abaratamiento de los costes al usar papeles y tintas de menor calidad y el uso de la lengua vulgar fue clave para que comenzase el proceso de alfabetización de la población europea. Y el acceso al conocimiento posibilitó que se desarrollara su capacidad crítica frente a verdades que hasta entonces se creían inmutables. Este cambio de actitud permitió la revolución científica que vendría en siglos posteriores. Revolución cuyo inicio podemos fechar en 1543. En este año fueron publicados dos hitos de la investigación científica: “De Humani Corporis Fabrica” de Andres Vesalio y “De Revolutionibus Orbium Coelestium” de Nicolás Copérnico. El primero marcó el comienzo de la investigación biológica sobre el cuerpo humano, el segundo acabó con la idea de que La Tierra es el centro del universo.

Categoría: Historia

Publicado por

AITRi

en

12:17 p. m.

16

comentarios

![]()

viernes, abril 28, 2006

El balón de fútbol

En la vida cotidiana, la regularidad con que se presentan los fenómenos nos resulta muy tranquilizadora. Al despertarnos por la mañana, esperamos que el mundo funcione en sus aspectos fundamentales como el día anterior. El sol sale aproximadamente a la misma hora, la taza que resbala entre nuestros dedos cae al suelo y se hace añicos, el balón de fútbol sigue la misma trayectoria siempre que se lance en las mismas condiciones, independientemente de la dirección en que se golpee. Estos hechos tan banales esconden un hecho mucho menos trivial: el espacio físico tiene un elevado grado de simetría ya que es homogéneo (invariante respecto a las traslaciones) e isótropo (invariante respecto a las rotaciones). En otras palabras, las leyes que gobiernan los fenómenos físicos no dependen del lugar ni de la dirección a la que se refieren.

Estas propiedades tan tranquilizadoras del espacio físico en que nos movemos tienen unas implicaciones en el mundo subatómico. Los electrones alrededor del núcleo se mueven de tal forma que el producto de su momento por la distancia al centro del átomo (el momento angular) sea proporcional a un número natural (0, 1, 2, 3…). En el lenguaje de la mecánica cuántica, se dice que el movimiento electrónico está cuantizado. Lo mismo puede decirse de los protones y neutrones, las partículas que componen el núcleo atómico. De esta manera, la acción de todas las partículas sobre cada una de ellas genera una “jaula esférica”, un campo medio de simetría esférica, donde todas las direcciones son equivalentes como requiere la isotropía del espacio, como en un balón de fútbol. Pero las cosas no son tan fáciles. Debido al propio movimiento de las partículas, este campo medio, el balón de fútbol, puede deformarse. Aparece una dirección distinta de las demás, como en un balón de rugby. Según las leyes de la mecánica cuántica no puede romperse la simetría de forma espontánea: el sistema comienza por tanto a girar en su conjunto para igualar todas las direcciones, se hace isótropo. La energía asociada a este movimiento (energía del punto cero) es un requisito ineludible de cualquier sistema mecano-cuántico que surge espontáneo a partir del desarrollo matemático. A menudo, esta energía ha sido empleada en la ficción (Alias, Los Increíbles, Star Trek,…) como “fuente de energía inagotable”. Sin embargo, a pesar de que puede ser experimentalmente detectada, no hay por el momento ninguna posibilidad de uso práctico en la realidad. La influencia de la energía del punto cero y el movimiento asociado a ella “sólo” se puede apreciar en la tranquilizadora trayectoria del balón de fútbol.

Publicado por

AITRi

en

10:27 a. m.

4

comentarios

![]()

miércoles, abril 26, 2006

El cerebro de los tunicados

Los tunicados viven en el fondo del mar. Tienen el aspecto de una botellita, con una piel delgada, de un color azulado. Su única actividad es bombear agua marina a su través, filtrarla y obtener nutrientes de ella. Inmóviles, anclados al fondo marino, no poseen cerebro porque no lo necesitan: tan solo tienen un mínimo sistema nervioso, que controla su aparato digestivo, para accionar la bomba de agua. No precisan saber qué hay fuera ni relacionarse: el agua los rodea y les proporciona todo.

Pero cuando estos seres se reproducen, generan una semilla inteligente que posee cerebro. Es una semilla móvil, como un renacuajo, capaz de responder a la luz, de distinguir arriba y abajo, de tener un cierto sentido táctil. En definitiva, la posibilidad de entender el mundo externo, aunque muy brevemente. Porque este tunicado con cerebro solo tiene una hora por delante, tiempo en el cual debe encontrar un lugar idóneo para establecerse durante el resto de su existencia. Durante su viaje, y dado que carece de aparato digestivo, se nutre de una yema que come a medida que va muriendo. Al fin, cuando encuentra el lugar propicio, se fija en él, mete la cabeza y absorbe su propio cerebro, porque ya no lo necesita.

Como apunta el propio Punset, hay gente que, al establecerse y encontrar un trabajo fijo, se comporta como el Ciona intestinalis, como los tunicados. Y es que la inteligencia está íntimamente ligada a la capacidad motriz. Sin movimiento, sin cambios inciertos a la vista, cuando ya no hay nada nuevo que aprender, el cerebro se convierte en algo superfluo.

No obstante, y esto es un comentario más personal, no se pretende con este ejemplo defender una postura teleológica entorno a la evolución biológica, en la que la necesidad vital hace que se desarrolle el órgano (en este caso, el cerebro). Se trata, más bien, de un ejemplo de adaptación evolutiva que a los tunicados les ha dado buen resultado. Por eso están ahí; su forma de vivir funciona. Y, a fin de cuentas, tan importante es para ellos su etapa “cerebral” como la de inmovilidad, sin la cual no serían capaces de formar las semillas con las que se reproducen. Quizás los humanos también necesitamos de esa alternancia de periodos de movimiento, de “inteligencia”, con periodos de confortable estabilidad.

Alberto Soldevilla

Categoría: Biología

Publicado por

AITRi

en

1:31 p. m.

8

comentarios

![]()

martes, abril 25, 2006

El fraude en el sistema de publicaciones científicas

Cuando un grupo de científicos estima que tiene un resultado reseñable, escribe un informe para que sea publicado en una de las miles de revistas científicas que existen. El editor de esta publicación, para dar el resultado como válido y por tanto publicable, lo enfrenta a la revisión por pares. En ésta, dos científicos, que trabajan en el mismo campo y por tanto tienen un alto grado de conocimiento del tema, revisan el trabajo y determinan si es válido para ser publicado. Un dato importante es que los autores desconocen la identidad de quien les va a evaluar y viceversa para eliminar los posibles tratos de favor. Pero, ¿qué se le pide a un resultado científico para ser publicado? Que sea nuevo, relevante y científico. O lo que es lo mismo, que no haya sido publicado nada semejante anteriormente, que los revisores encuentren el trabajo interesante para la rama de estudio en cuestión y que la investigación se haya realizado con los procedimientos que se consideran dentro del método científico. Así, los pares no repiten la investigación. Tan sólo se aseguran de que sea verosímil, esté bien razonada, sea acorde con el conocimiento disponible y pueda ser fructífera para otros científicos.

Según lo explicado y al no comprobarse la reproducibilidad de los resultados antes de su publicación, un científico que se inventase los datos podría pasar este control fácilmente si los enmascarase dentro de un procedimiento que se considerase verosímil y científico. Así es pero este hecho no debe llevar a la alarma. Hay que comprender que el proceso científico no finaliza con la publicación, hecho que sólo representa un punto y seguido. Al publicarse los resultados, estos quedarán libres y serán leídos por la comunidad científica. Sí son interesantes, lo que se les presupone ya que han pasado la revisión por pares, es muy posible que sirvan de base a nuevos estudios de otros grupos científicos. Estos, como primer paso, tratarán de repetir los resultados obtenidos en la publicación y así, el posible fraude quedará al descubierto. Por tanto, toda la comunidad científica actúa como verdadera controladora del proceso y es tremendamente dura ya que el prestigio de todo el grupo está en juego.

Cualquier sistema colectivo creado por el hombre es susceptible de ser corrompido por el engaño, conducta que parece en mayor o menor medida inherente al ser humano. Por tanto es fundamental un sistema controlador. El que posee la comunidad científica, que ha puesto al descubierto los casos de fraude conocidos y lleva tres siglos demostrando su utilidad, parece que goza de buena salud pero no se debe bajar la guardia; el error siempre acecha.

David Sucunza

Categoría: Ciencia

Publicado por

AITRi

en

9:24 a. m.

2

comentarios

![]()

lunes, abril 24, 2006

Porqué también historia (Sobre el lugar de la historia entre las ciencias)

Tal vez sorprenda la decisión de incluir la historia en este weblog de "Ciencia para impacientes". Hay para ello al menos una razón histórica: el presente proyecto lo ha puesto en marcha la AITRi, Asociación de Investigadores y Tecnólogos de La Rioja, que nació para agrupar a los becarios de investigación riojanos con independencia de la disciplina académica a la que se dedicaran, incluidos los de "letras", como quien esto escribe.

Por mi parte, parte interesada, lo confieso, por cuanto soy historiador de oficio y vocación, añadiré también una razón epistemológica. Y vaya por delante que no considero el criterio que expondré incontrovertible, aunque sí razonable, y que si lo lanzo al ciberespacio es con la esperanza de que sea sometido a crítica, en particular desde el lado de las "ciencias" (entendiendo por éstas, en adelante, las ciencias naturales o experimentales), algo de lo que sólo pueden resultar beneficios mutuos.

Me propongo demostras que tanto las "ciencias" como la historia comparten unas mismas premisas metodológicas y que éstas les conducen a resultados igualmente ciertos, aunque reconociendo que ambas se diferencian en cuanto a los métodos y en cuento al tipo de conocimiento que proporcionan.

Las "ciencias" no describen con exactitud la realidad, no ofrecen un mapa completo de las-cosas-tal-y-como-son, sino que describen algunos aspectos, empíricamente perceptibles, de la realidad. Hay una parte de la realidad que resulta incognoscible, y otra que todavía nos es desconocida, pero no por ello los modelos y leyes científicas, incompletos en cuanto imagen del Todo, dejan de ser útiles para permitirnos conocer cómo suceden las cosas que sí podemos verificar. Por otra parte, para ser aceptada una teoría científica debe poder confrontarse con los hechos empíricos, quedando validada, de modo provisional, si se adapta a ellos, o invalidada en caso contrario, aunque más frecuentemente, dado lo difícil que es establecer teorías generales, acaba siendo parcheada con limitaciones y excepciones para dar cuenta de los comportamientos anómalos que la contradicen.

La historia comparte con las "ciencias" los dos rasgos mecionados. Para defender este principio seguiré a continuación el razonamiento elaborado por E. P. Thompson en Miseria de la teoría (The Poverty of Theory or an Orrery of Errors, 1978), en parte polemizando con las críticas de Karl Popper (The Poverty of Historicism, 1961), aunque la obra constituyera primordialmente una réplica a la teoría marxista desarrollada por Louis Althusser (Pour Marx, 1965, y Lire le Capital, 1968).

El pasado tiene al menos la misma cualidad empírica que el presente. Pasan cosas, han pasado cosas, y eso es un dato incontestable. Debido a la naturaleza de las fuentes, el historiador no recibe todos los datos de todo lo que sucedió en el pasado; pero sí una parte. Estos datos ofrecen un límite a las teorías, las explicaciones, que pueden proponerse sobre el pasado, y al mismo tiempo constituyen el elemento que posibilita llevar a cabo la verificación o la invalidación de dichas teorías, que también pueden ser sometidas, como las de las "ciencias", a "falsación", a contraste con los hechos empíricos. Del mismo modo, al igual que las "ciencias", la historia tampoco proporciona una imagen de las cosas-tal-como-fueron, sino una aproximación provisional a ellas.

Sí que hay que reconocer, no obstante, y Thompson así lo hizo, que el tipo de conocimiento que proporciona la historia se diferencia del suministrado por las "ciencias" en que el histórico tiene un carácter flexible y no conduce al establecimiento de leyes que faculten a los historiadores a hacer predicciones fiables (esto es, a profetizar el futuro). Puede considerarse en este sentido que el histórico es un conocimiento más débil que el de las "ciencias", aunque no por ello improcedente o inservible. Los conceptos históricos, tales como "explotación", "lucha de clases" o "crisis de subsistencias", no son tanto "modelos" y "reglas" como "expectativas" que ayudan a ordenar e interpretar los datos y describen pautas probables, siempres sujetas a variación y contingencia. Tienen por tanto carácter orientativo, no normativo. Del mismo modo, las causas históricas son necesarias, pero no suficientes, y la labor del historiador es mostrar porqué acontecieron las cosas de una manera y no de otra, y nunca pretender demostrar que tal desarrollo era inevitable.

Las expectativas que genera el conocimiento histórico en combinación con el conocimiento del presente deben su carácter falible a la gran cantidad de factores interrelacionados, imprevisible y, en última instancia, incognoscible, implicados en los procesos históricos. El devenir de la historia presenta contingencias mucho mayores, no ya que la verificación de un fenómeno físico o químico en ausencia de las condiciones controladas del laboratorio, sino también que la materia de conocimiento de otras disciplinas, como la medicina o la biología, también comprometidas en sus predicciones por el comportamiento de seres vivos, siempre perturbador.

En tanto conocimiento sujeto a modificicación y aproximado, provisional e incompleto, pero dependiente de hechos realmente acaecidos, y que ofrece descripciones relevantes, y sometidas a controles de verificación, de los acontecimientos del pasado y de los procesos implicados en su desarrollo, creo que la historia tiene todo el derecho a figurar en este weblog con un espacio propio. Y que al compartir con las "ciencias" (de la naturaleza o experimentales) un mismo lugar para la divulgación de resultados y la reflexión metodológica contribuirá a acercarnos a una comprensión más ajustada del mundo en el que vivimos, tanto a quienes hacemos el weblog como a quienes se animen a curiosear en él.

Categoría: Historia

Publicado por

AITRi

en

7:54 p. m.

1 comentarios

![]()

miércoles, abril 12, 2006

Saludos navegantes

Esta es la primera contribución a esta bitácora de “Ciencia para Impacientes” donde pretendemos dar espacio a la reflexión, al debate, a la efeméride y en general a todo aquello relacionado con la comunicación científica en un formato breve y ameno. Nuestro deseo es el de mostrar la Ciencia tal y como es, sin metalenguajes y cercana a la sociedad. Hoy en día los asuntos de los que se ocupan los científicos se han convertido en una sección más de los periódicos, unas veces a modo de mercancías, otras aportando nuevas esperanzas… la Ciencia no está libre de nuestra propia humanidad.

La AITRi nació con un espíritu reivindicativo, diciendo aquello de "investigar es un trabajo" y que los que empiezan en este negocio deberían de tener los mismos derechos que el que decide iniciarse en cualquier otra profesión. Desde el 2003 definimos como nuestra línea de trabajo para continuar con esta reivindicación la divulgación científica. Así comenzó la primera edición del Certamen Teresa Pinillos de Ensayos de Divulgación Científica, del cual lanzamos en estos días su III edición.

Hoy con esta bitácora o blog (confieso que prefiero lo castizo) pretendemos continuar con este trabajo y confiamos en que remedie a todos aquellos “impacientes” que se atrevan a navegar por nuestras aguas, unas veces mansas y otras... no tanto.

Nos vemos.

José Ignacio Barriobero

Categoria: Aitri

Publicado por

AITRi

en

10:01 a. m.

1 comentarios

![]()

Blog

Blog